” 中文分词“ 的搜索结果

本文首先介绍下中文分词的基本原理,然后介绍下国内比较流行的中文分词工具,如jieba、SnowNLP...中文分词(Chinese Word Segmentation) 指的是将一个汉字序列切分成一个一个单独的词。分词就是将连续的字序列按照一...

中文分词词库整理.7z

标签: 中文分词

中文分词词库整理.7z

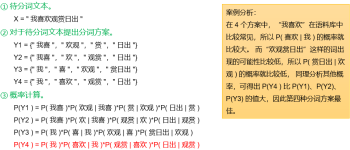

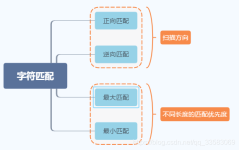

中文分词的概念与分类 常用分词(规则分词、统计分词、混合分词)技术介绍 开源中文分词工具-Jieba 实战分词之高频词提取 3.1 中文分词简介 规则分词 最早兴起,主要通过人工设立词库,按照一定方式进行...

中文分词(Chinese Word Segmentation) 指的是将一个汉字序列切分成一个一个单独的词。分词就是将连续的字序列按照一定的规范重新组合成词序列的过程。 中文分词是其他中文 (信息) 处理的基础,搜索引擎、机器翻译...

中文分词指的是将一个汉字序列切分成一个一个单独的词。分词就是将连续的字序列按照一定的规范重新组合成词序列的过程。

百度以前用的中文分词词典,希望对大家有一点帮助

ik中文分词词库35万中文分词词库(含电商)

中文分词词库大全词库

标签: 分词 词库 中文分词

这是前一段时间我在研究中文分词时在网上找到的一个词典,TXT格式的,拿出来分享一下。这是前一段时间我在研究中文分词时在网上找到的一个词典,TXT格式的,拿出来分享一下。这是前一段时间我在研究中文分词时在网上...

基于HMM的中文分词代码,虽然基于字标注的中文分词借鉴了词性标注的思想,但是在实践中,多数paper中的方法似乎局限于最大熵模型和条件随机场的应用,所以我常常疑惑字标注中文分词方法为什么不采用别的模型和方法呢...

中文分词词库,中文词库20万(19万6千),自己整理的,用于做中文分词,根据一段话,或者一篇文章进行拆词都可以使用的上。

中文分词是中文文本处理的一个基础性工作,结巴分词利用进行中文分词。 其基本实现原理有三点: 1.基于Trie树结构实现高效的词图扫描,生成句子中汉字所有可能成词情况所构成的有向无环图(DAG) 2.采用了动态规划...

30万 中文分词词库.txt 42537条伪原创词库.txt 百度分词词库.txt 词库地址.txt 词库下载地址.txt

分词词库_中文分词词库最新整理(TXT格式)

分词数据集,用于训练一个用来分词的模型。详细看压缩包里的内容。

汇总的中文分词词库,分为两个目录: 1、中文分词词库汇总。包含10个词库,文件名字表示里面词的数量(单位是千),如150.txt,表示包含15万词。 2、主流分词工具的词库。包含word/jieba/mmseg/IK分词工具的最近词库...

实现基于HMM的序列标注中文分词,并将分词准确率与实验一进行比较。 包含停用词语料,人民日报标准切分语料 HMM分词程序 HMM评估程序

汉字的组合也是变化多端,麻将这个项目希望能从汉字组合中发现汉语的秘密,为自然语言处理提供好的中文分词工具。 麻将是基于Scala的语言实现的中文分词软件包。这个项目的核心是最大概率分词,整个项目专为搜索...

在使用jiba分词的情况下,使用这个词典有助于提高你的分词准确度,因为这个分词词典包含了众多领域词汇,这些词汇出自某dog的几十个细胞词库。已使用转换器转换成txt,欢迎下载。

30万 中文分词词库.txt

标签: 分词词库

30万 中文分词词库.txt

通过以上的序列标注,那么我们可以得到这个HMM模型:状态空间为{B,E,M,S}每个字就是模型中的观测,所以观测空间为语料中的所有中文字两个空间完了,还需要三个

结巴中文分词停用表,整合百度分词、哈工大等停用词表2000余条数据 即拿即用,效果好,提升分词速度准确率。

中文分词指将一个汉字序列切分成一个个单独的词。 中文分词的难题 分词规则(粒度)问题:不同应用对粒度的要求不一样,比如“百度搜索”可以是一个词也可以是两个词 消除歧义问题:比如“小吃店关门了” 未登录词...

Elasticsearch电商平台中文分词词库

中文分词 关键字提取 工具类详细文档 每秒60W字的处理量

HMMSegment使用HMM进行中文分词。

Scala中文分词+SparkML逻辑回归 实现 中文文本分类

读取词表,按照最大正向匹配法给中文分词。然后么,大家都懂的。只是一个课程练习。大家不要太当真

中文分词本项目为中文分词任务baseline的代码实现,模型包括BiLSTM-CRF 基于BERT的+ X(softmax / CRF / BiLSTM + CRF) 罗伯塔+ X(softmax / CRF / BiLSTM + CRF)本项目是的项目。数据集数据集第二届中文分词任务...

推荐文章

- cocos creator 实现截屏截图切割转成 base64分享--facebook小游戏截图base64分享,微信小游戏截图分享【白玉无冰】每天进步一点点_cocos上传base64-程序员宅基地

- Docker_error running 'docker: compose deployment': server-程序员宅基地

- ChannelSftp下载目录下所有或指定文件、ChannelSftp获取某目录下所有文件名称、InputStream转File_channelsftp.lsentry获取文件全路径-程序员宅基地

- Hbase ERROR: Can‘t get master address from ZooKeeper; znode data == null 解决方案_error: can't get master address from zookeeper; zn-程序员宅基地

- KMP的最小循环节_kmp求最小循环节-程序员宅基地

- 详解ROI-Pooling与ROI-Align_roi pooling和roi align-程序员宅基地

- Imx6ull开发板Linux常用查看系统信息指令_armv7 processor rev 2 (v7l)-程序员宅基地

- java SSH面试资料-程序员宅基地

- ant design vue table 高度自适应_对比1万2千个Vue.js开源项目发现最实用的 TOP45!火速拿来用!...-程序员宅基地

- 程序员需要知道的缩写和专业名词-程序员宅基地